Negocios

De la fotosíntesis al ADN: 5 lecciones de la naturaleza que están redefiniendo la informática

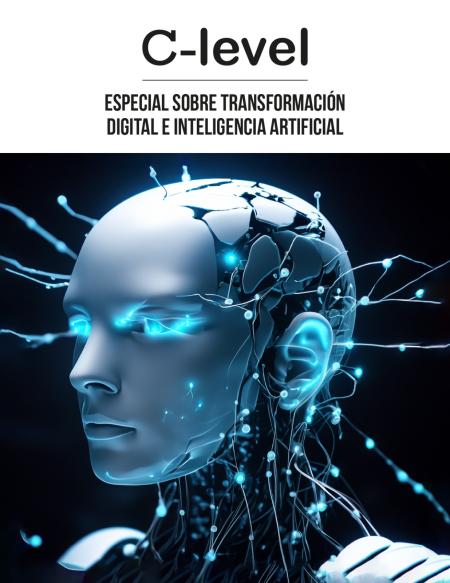

Inspirada en el cerebro, el ADN y la fotosíntesis, la informática adopta principios biológicos para superar límites del silicio y la Ley de Moore.

Domingo, Septiembre 14, 2025

Durante décadas, la Ley de Moore fue la brújula del progreso en la informática. Sin embargo, los límites físicos del silicio y el creciente consumo energético de la inteligencia artificial han marcado un punto de inflexión. Hoy, los tecnólogos buscan respuestas en otro lugar: las lecciones de la naturaleza.

Cinco principios que inspiran la tecnología

El cerebro y la eficiencia energética

Con apenas 20 vatios, el cerebro humano rivaliza con supercomputadores como Frontier, que requieren 20 megavatios. Esta capacidad inspira la computación neuromórfica, replicada en chips como IBM TrueNorth e Intel Loihi.El ADN como disco duro del futuro

Un gramo de ADN puede almacenar hasta 215 petabytes de datos. Microsoft y la Universidad de Washington avanzan en métodos para abaratar y acelerar el proceso, lo que podría transformar los centros de datos en laboratorios de biotecnología.Inteligencia de enjambre

Inspirados en colonias de hormigas y abejas, los algoritmos de optimización colectiva permiten a sectores como logística y telecomunicaciones lograr eficiencias superiores al 99,9% en enrutamiento.Resiliencia biológica aplicada a la nube

Así como la naturaleza se adapta a los errores, la infraestructura digital adopta autocuración y redundancia, esenciales en edge computing y sistemas autónomos.Fotosíntesis y computación fotónica

La clorofila canaliza energía con una eficiencia casi perfecta. Este modelo inspira a los procesadores fotónicos, que prometen reducir el consumo energético de la IA entre 10 y 50 veces.

Un nuevo paradigma

Más que superar a la naturaleza, la tecnología comienza a colaborar con ella. La eficiencia, la densidad de almacenamiento, la resiliencia y la inteligencia colectiva son ahora los pilares de una informática sostenible y adaptativa.

“El futuro de la informática no radica en chips más pequeños, sino en sistemas que aprenden de millones de años de evolución”, concluye el análisis de ManageEngine.